Apache Spark es una herramienta de análisis de datos que se puede utilizar para procesar datos de HDFS, S3 u otras fuentes de datos en memoria. En este post, instalaremos Apache Spark en una máquina Ubuntu 17.10.

Versión de Ubuntu

Para esta guía, usaremos la versión 17.10 de Ubuntu(GNU / Linux 4.13.0-38-generic x86_64).

Apache Spark es parte del ecosistema Hadoop para Big Data. Pruebe a instalar Apache Hadoop y haga una aplicación de ejemplo con ella.

Actualización de paquetes existentes

Para iniciar la instalación de Spark, es necesario que actualicemos nuestra máquina con los últimos paquetes de software disponibles. Podemos hacer esto con:

Como Spark está basado en Java, necesitamos instalar en nuestro equipo. Podemos usar cualquier versión de Java por encima de Java 6. Aquí, usaremos Java 8:

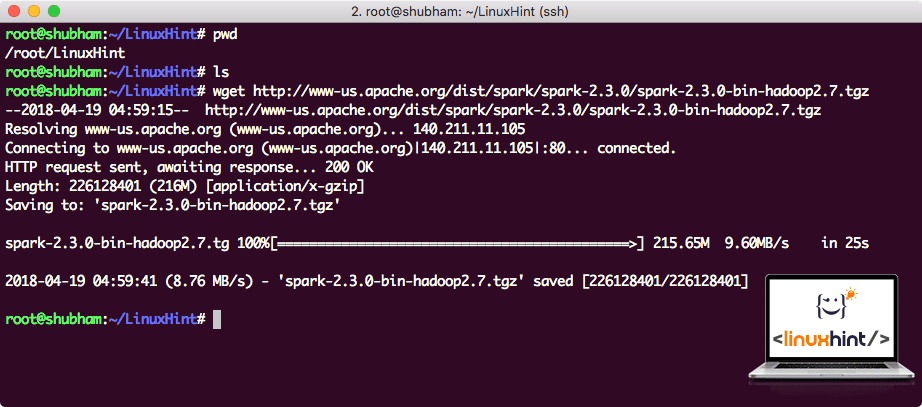

Descargando archivos Spark

Todos los paquetes necesarios ahora existen en nuestra máquina. Estamos listos para descargar los archivos TAR de Spark necesarios para que podamos comenzar a configurarlos y ejecutar un programa de muestra con Spark también.

En esta guía, instalaremos Spark v2.3. 0 disponible aquí:

Página de descarga de Spark

Descargue los archivos correspondientes con este comando:

Dependiendo de la velocidad de la red, esto puede tardar hasta unos minutos, ya que el archivo es de gran tamaño:

Descargando Apache Spark

Ahora que tenemos el archivo TAR descargado, podemos extraer en el directorio actual:

Esto tardará unos segundos en completarse debido al gran tamaño del archivo:

Archivos no archivados en Spark

Cuando se trata de actualizar Apache Spark en el futuro, puede crear problemas debido a las actualizaciones de rutas. Estos problemas se pueden evitar creando un enlace suave a Spark. Ejecute este comando para crear un enlace suave:

Agregar Spark a la ruta

Para ejecutar scripts de Spark, lo agregaremos a la ruta ahora. Para hacer esto, abra el archivo bashrc:

Agregue estas líneas al final de la .archivo bashrc para que esa ruta pueda contener la ruta del archivo ejecutable Spark:

export PATH = SPARK SPARK_HOME / bin:PATH PATH

Ahora, el archivo se ve como:

Agregar Spark a la RUTA

Para activar estos cambios, ejecute el siguiente comando para el archivo bashrc:

Iniciando Shell de Spark

Ahora que estamos justo fuera del directorio de spark, ejecute el siguiente comando para abrir el shell de apark:

Veremos que Spark shell está abierto ahora:

Lanzamiento de Spark shell

Podemos ver en la consola que Spark también ha abierto una consola Web en el puerto 404. Démosle una visita:

Consola Web Apache Spark

Aunque operaremos en la propia consola, el entorno web es un lugar importante al que debe prestar atención cuando ejecuta trabajos pesados de Spark para que sepa lo que está sucediendo en cada trabajo de Spark que ejecuta.

Compruebe la versión de shell de Spark con un simple comando:

Recuperaremos algo como:

Crear una aplicación Spark de ejemplo con Scala

Ahora, haremos una aplicación de contador de palabras de ejemplo con Apache Spark. Para hacer esto, primero cargue un archivo de texto en el contexto de Spark en el shell de Spark:

Data: org.apache.chispa.rdd.RDD = / root / LinuxHint/spark / README.md MapPartitionsRDD en el archivo de texto en :24

scala>

Ahora, el texto presente en el archivo debe dividirse en tokens que Spark pueda administrar:

tokens: org.apache.chispa.rdd.RDD = MapPartitionsRDD en Mapa plano en: 25

scala>

Ahora, inicialice el recuento de cada palabra para 1:

tokens_1: org.apache.chispa.rdd.RDD = cartografíasrdd en el mapa en: 25

scala>

Finalmente, calcule la frecuencia de cada palabra del archivo:

Es hora de mirar la salida del programa. Recoge las fichas y sus respectivos recuentos:

res1: Array = Array ((paquete,1), (Para,3), (Programas,1), (procesamiento.,1), (Porque, 1), (El, 1), (página] (http://spark.apache.org/documentation.html)., 1), (grupo.,1), (su,1), ([ejecutar,1), (de,1), (Api,1), (han,1), (Pruebe,1), (computación,1), (a través de,1), (varios,1), (Este,2), (gráfico 1), (Colmena,2), (almacenamiento,1), ([«Especificar,1), (A,2), («hilo»,1), (una Vez,1), ([«Útil,1), (prefiere,1), (SparkPi,2), (motor,1), (versión 1), (archivo,1), (documentación,1), (procesamiento,1), (el,24), (son,1), (sistemas.,1), (params,1), (no,1), (diferentes,1), (consulte,2), (Interactivo,2), (R,1), (dada.,1), (if, 4), (build, 4), (when, 1), (be, 2), (Tests, 1), (Apache, 1), (thread, 1), (programs,, 1), (including, 4), (./ bin / run-ejemplo, 2), (Spark., 1), (paquete.,1), (1000).count(),1), (Versiones,1), (HDFS,1), (D…

scala>

Excelente! Pudimos ejecutar un ejemplo de Contador de palabras simple usando el lenguaje de programación Scala con un archivo de texto ya presente en el sistema.

Conclusión

En esta lección, vimos cómo podemos instalar y comenzar a usar Apache Spark en la máquina Ubuntu 17.10 y ejecutar una aplicación de ejemplo en ella también.

Lea más publicaciones basadas en Ubuntu aquí.