Apache Spark on data-analytiikkatyökalu, jolla voidaan käsitellä HDFS: n, S3: n tai muiden tietolähteiden tietoja muistissa. Tässä viestissä asennamme Apache Sparkin Ubuntu 17.10-koneeseen.

Ubuntun versio

tässä oppaassa käytetään Ubuntun versiota 17.10 (GNU/Linux 4.13.0-38-generic x86_64).

Apache Spark on osa Hadoop-ekosysteemiä Big datalle. Kokeile asentaa Apache Hadoop ja tehdä näyte sovellus sen kanssa.

olemassa olevien pakettien päivittäminen

Spark-asennuksen käynnistämiseksi on välttämätöntä, että päivitämme koneemme uusimmilla saatavilla olevilla ohjelmistopaketeilla. Voimme tehdä tämän:

koska Spark perustuu Javaan, se on asennettava koneeseemme. Voimme käyttää mitä tahansa Java-versiota Java 6: n yläpuolella. Täällä, käytämme Java 8:

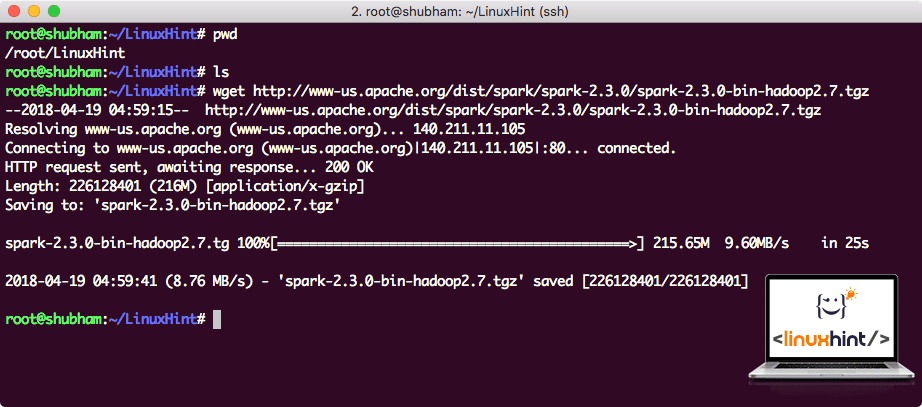

lataamalla kipinä-tiedostoja

kaikki tarvittavat paketit ovat nyt koneellamme. Olemme valmiita lataamaan tarvittavat Spark TAR-tiedostot, jotta voimme aloittaa niiden perustamisen ja ajaa näytteen ohjelman Spark samoin.

tässä oppaassa asennetaan Spark v2. 3. 0 saatavilla täältä:

Spark download page

Lataa vastaavat tiedostot tällä komennolla:

riippuen verkon nopeus, tämä voi kestää jopa muutaman minuutin, koska tiedosto on suuri kooltaan:

Ladataan Apache Spark

nyt kun TAR-tiedosto on ladattu, voimme purkaa sen nykyisestä hakemistosta:

tämän valmistumiseen menee muutama sekunti johtuen arkiston suuresta tiedostokoosta:

Arkistoimattomat tiedostot Sparkissa

Kun Apache Sparkia on tarkoitus päivittää tulevaisuudessa, se voi aiheuttaa ongelmia Polkupäivitysten vuoksi. Nämä ongelmat voidaan välttää luomalla softlink Sparkiin. Suorita tämä komento tehdäksesi softlinkin:

lisäämällä Spark polulle

Spark-skriptien toteuttamiseksi, lisäämme sen polulle nyt. Voit tehdä tämän avaamalla bashrc-tiedoston:

lisää nämä rivit loppuun .bashrc-tiedosto, jotta polku voi sisältää Spark-suoritettavan tiedoston polun:

export PATH = $SPARK_HOME/bin:$PATH

nyt tiedosto näyttää:

kipinä polkuun

aktivoidaksesi nämä muutokset, suorita seuraava komento bashrc-tiedostolle:

Launching Spark Shell

Now when we are right outside the spark directory, run the following command to open apark shell:

näemme, että Spark shell on nyt auki:

Launching Spark shell

konsolista näkyy, että Spark on avannut myös web-konsolin porttiin 404. Käydään siellä.:

Apache Spark Web Console

vaikka toimimme itse konsolilla, web-ympäristö on tärkeä paikka tarkastella, kun suoritat raskaita Spark-töitä, jotta tiedät, mitä jokaisessa Suorittamassasi Spark-työssä tapahtuu.

Tarkista Spark shell-versio yksinkertaisella komennolla:

saamme takaisin jotain:

tehden sample Spark-sovelluksen Scala

nyt teemme sample Word Counter-sovelluksen Apache Sparkilla. Voit tehdä tämän lataamalla ensin tekstitiedoston Spark-kontekstiin Spark Shellissä:

Data: org.apassit.kipinä.rdd.RDD = / root / LinuxHint/spark/README. md MapPartitionsRDD tekstitiedostossa osoitteessa :24

scala>

nyt, Teksti läsnä tiedostossa on jaettava poletteihin, jotka Spark voi hallita:

tokens: org.apassit.kipinä.rdd.RDD = MapPartitionsRDD flatmapissa: 25

scala>

nyt, alustaa määrä kunkin sanan 1:

tokens_1: org.apassit.kipinä.rdd.RDD = MapPartitionsRDD kartalla osoitteessa: 25

scala>

lopuksi lasketaan tiedoston jokaisen sanan taajuus:

aika katsoa ohjelman tuotosta. Kerää kuponkien ja niiden määrä:

res1: Array = Array ((Paketti,1), (varten,3), (ohjelmat,1), (käsittely., 1), (Koska, 1), (, 1), (sivu] (http://spark.apache.org/documentation.html)., 1), (klusteri.,1), (its,1), ([run,1), (than,1), (API,1), (have,1), (Try,1), (computation,1), (through,1), (several,1), (This,2), (graph,1), (Hive,2), (storage,1), ([”Specifying,1), (To,2), (”Lanka”,1), (Once,1), ([”hyödyllinen,1), (prefer,1), (sparkpi,2), (Moottori,1), (versio,1), (tiedosto,1), (dokumentaatio,,1), (käsittely,,1), (, 24), (ovat,1), (järjestelmät.,1), (params,1), (not,1), (different,1), (refer,2), (Interactive,2), (R,,1), (given.,1), (Jos, 4), (rakentaa, 4), (Kun, 1), (be, 2), (testit, 1), (Apache, 1), (säie, 1), (ohjelmat,, 1), (mukaan lukien, 4), (./ bin / run-esimerkki,2), (kipinä., 1), (paketti.,1), (1000).lukumäärä (), 1), (versiot, 1), (HDFS, 1), (D…

scala>

loistavaa! Pystyimme ajamaan yksinkertaisen Sanalaskurin esimerkin käyttämällä Scala – ohjelmointikieltä, jossa oli jo järjestelmässä oleva tekstitiedosto.

johtopäätös

tällä oppitunnilla tarkastelimme, miten voimme asentaa ja aloittaa Apache Sparkin käytön Ubuntu 17.10-koneessa ja ajaa näytesovelluksen myös siihen.

Lue lisää Ubuntu – pohjaisia julkaisuja täältä.