az Apache Spark egy adatelemző eszköz, amely HDFS, S3 vagy más adatforrásokból származó adatok feldolgozására használható a memóriában. Ebben a bejegyzésben az Apache Sparkot telepítjük egy Ubuntu 17.10 gépre.

Ubuntu Verzió

ebben az útmutatóban az Ubuntu 17.10 verzióját fogjuk használni (GNU/Linux 4.13.0-38-generic x86_64).

az Apache Spark a Hadoop ökoszisztéma része a Big Data számára. Próbálja meg telepíteni az Apache Hadoop-ot, és készítsen vele egy mintaalkalmazást.

meglévő csomagok frissítése

a Spark telepítésének megkezdéséhez szükséges, hogy frissítsük gépünket a rendelkezésre álló legújabb szoftvercsomagokkal. Ezt megtehetjük:

mivel a Spark Java alapú, telepítenünk kell a gépünkre. Bármely Java verziót használhatunk a Java 6 felett. Itt a Java 8-at fogjuk használni:

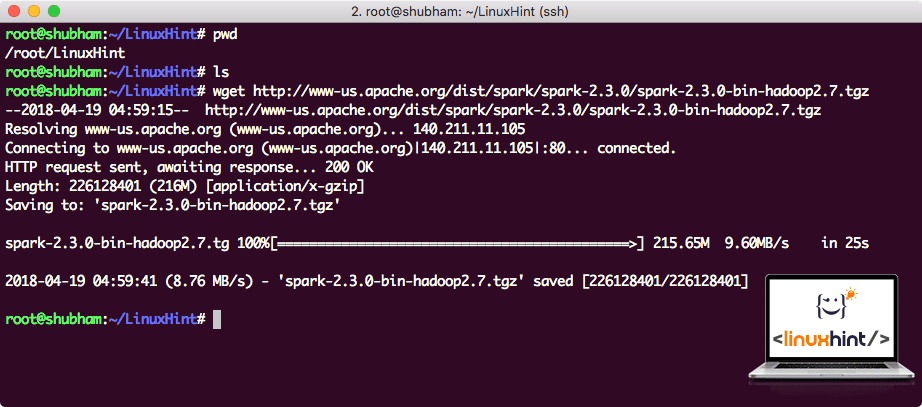

Spark fájlok letöltése

minden szükséges csomag már létezik a gépünkön. Készen állunk a szükséges Spark tar fájlok letöltésére, hogy elkezdhessük a beállításukat, és egy mintaprogramot is futtathassunk a Spark segítségével.

ebben az útmutatóban, mi lesz telepítése Spark v2.3.0 elérhető itt:

Spark letöltési oldal

töltse le a megfelelő fájlokat ezzel a paranccsal:

a hálózati sebességtől függően ez akár néhány percet is igénybe vehet, mivel a fájl nagy méretű:

Apache Spark letöltése

most, hogy letöltöttük a TAR fájlt, kibonthatjuk az aktuális könyvtárban:

ez néhány másodpercet vesz igénybe az archívum nagy fájlmérete miatt:

Archiválatlan fájlok a Spark-ban

amikor az Apache Spark jövőbeli frissítéséről van szó, problémákat okozhat az elérési út frissítései miatt. Ezeket a problémákat el lehet kerülni egy softlink to Spark létrehozásával. Futtassa ezt a parancsot softlink létrehozásához:

Spark hozzáadása az elérési úthoz

a Spark szkriptek végrehajtásához most hozzáadjuk az elérési úthoz. Ehhez nyissa meg a bashrc fájlt:

Add ezeket a sorokat, hogy a végén a .bashrc Fájl, hogy az elérési út tartalmazhassa a Spark futtatható fájl elérési útját:

export elérési út=$SPARK_HOME/kuka:$elérési út

most a fájl úgy néz ki, mint:

elérési úthoz a Spark hozzáadása a

elérési úthoz a módosítások aktiválásához futtassa a következő parancsot a bashrc fájlhoz:

A Spark Shell elindítása

Most, amikor a spark könyvtáron kívül vagyunk, futtassa a következő parancsot az apark shell megnyitásához:

látni fogjuk, hogy a Spark shell most nyitva van:

Spark shell indítása

a konzolon láthatjuk, hogy a Spark egy webes konzolt is megnyitott a 404-es porton. Nézzük, hogy egy látogatás:

Apache Spark Web Console

bár mi fog működni a konzol maga, webes környezet fontos hely, hogy nézd meg, ha végre nehéz Spark feladatokat, hogy tudja, mi történik minden Spark munkát hajt végre.

ellenőrizze a Spark shell verzióját egy egyszerű paranccsal:

mi lesz vissza valami hasonló:

így egy minta Spark alkalmazás Scala

most, mi lesz, hogy egy minta szót számláló alkalmazás Apache Spark. Ehhez először töltsön be egy szöveges fájlt a Spark környezetbe a Spark shell-en:

adatok: org.apacs.szikra.rdd.RDD = / root / LinuxHint / spark / README. md Mappapartitionsrdd a textFile címen :24

scala>

most a fájlban lévő szöveget tokenekre kell bontani, amelyeket a Spark képes kezelni:

tokenek: org.apacs.szikra.rdd.RDD = Mapppartitionsrdd at flatMap at: 25

scala>

most inicializálja az egyes szavak számát 1:

tokens_1: org.apacs.szikra.rdd.RDD = Térképpartitionsrdd at map at: 25

scala>

végül számítsa ki a fájl minden szavának gyakoriságát:

ideje megnézni a program kimenetét. Gyűjtsd össze a tokeneket és azok számát:

res1: Array = Array ((csomag,1), (For,3), (Programok,1), (feldolgozás.,1), (mert, 1), (Az, 1), (oldal](http://spark.apache.org/documentation.html)., 1), (klaszter.,1), (its,1), ([run,1), (mint,1), (API-k,1), (van,1), (Try,1), (számítás,1), (keresztül,1), (Több,1), (Ez,2), (grafikon,1), (Kaptár,2), (tárolás,1), ([“meghatározása,1), (nak nek,2), (“fonal”,1), (egyszer,1), ([“Hasznos,1), (inkább,1), (sparkpi,2), (motor,1), (változat,1), (fájl,1), (dokumentáció,,1), (feldolgozás,,1), (az,24), (vannak,1), (rendszerek.,1), (params, 1), (nem, 1), (Különböző, 1), (refer, 2), (interaktív, 2), (R,, 1), (adott.,1), (ha, 4), (build, 4), (Amikor, 1), (be, 2), (tesztek, 1), (Apache, 1), (szál, 1), (programok,, 1), (beleértve, 4), (./ bin / run-példa,2), (szikra.,1), (csomag.,1), (1000).count(),1), (változatok, 1), (HDFS, 1), (D…

scala>

kitűnő! Egy egyszerű Word Counter példát tudtunk futtatni a Scala programozási nyelv használatával, a rendszerben már jelen lévő szöveges fájllal.

következtetés

ebben a leckében azt vizsgáltuk, hogyan telepíthetjük és kezdhetjük el használni az Apache Sparkot Ubuntu 17.10 gépen, és futtathatunk rajta egy mintaalkalmazást is.

további Ubuntu alapú Hozzászólások itt.