Apache Sparkは、HDFS、S3、またはメモリ内の他のデータソースからのデータを処理するために使 この記事では、Ubuntu17.10マシンにApache Sparkをインストールします。このガイドでは、Ubuntuバージョン17.10(GNU/Linux4.13.0-38-generic x86_64)を使用します。

Apache SparkはビッグデータのためのHadoopエコシステムの一部です。 Apache Hadoopをインストールして、サンプルアプリケーションを作成してみてください。

既存のパッケージの更新

Sparkのインストールを開始するには、利用可能な最新のソフトウェアパッケージでマシンを更新する必要があります。 私たちはこれを行うことができます:

SparkはJavaに基づいているため、マシンにインストールする必要があります。 Java6より上の任意のJavaバージョンを使用できます。 ここでは、Java8を使用します:

Sparkファイルのダウンロード

必要なパッケージがすべてマシンに存在します。 必要なSpark TARファイルをダウンロードして、それらの設定を開始し、Sparkでサンプルプログラムを実行する準備が整いました。

このガイドでは、ここで利用可能なSpark v2.3.0をインストールします:

Sparkダウンロードページ

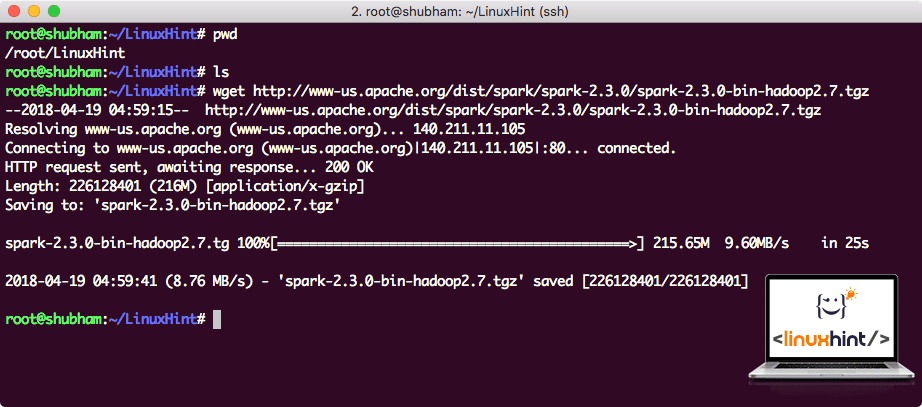

このコマンドで対応するファイルをダウンロードします:

ネットワーク速度によっては、ファイルのサイズが大きいため、これには数分かかることがあります:

Apache Sparkのダウンロード

TARファイルをダウンロードしたので、現在のディレクトリで抽出できます:

アーカイブのファイルサイズが大きいため、これは完了するまでに数秒かかります:

Sparkの未アーカイブファイル

将来的にApache Sparkをアップグレードすると、パスの更新による問題が発生する可能性があ これらの問題は、Sparkへのソフトリンクを作成することで回避できます。 次のコマンドを実行してソフトリンクを作成します:

パスにSparkを追加する

Sparkスクリプトを実行するために、今それをパスに追加します。 これを行うには、bashrcファイルを開きます:

これらの行を最後に追加します。pathにSpark実行可能ファイルのパスを含めることができるようにbashrcファイル:

export PATH=$SPARK_HOME/bin:PATH PATH

さて、ファイルは次のようになります:

パスへのSparkの追加

これらの変更を有効にするには、bashrcファイルに対して次のコマンドを実行します:

Sparkシェルの起動

sparkディレクトリのすぐ外にいるときは、次のコマンドを実行してaparkシェルを開きます:

Sparkシェルがopenendであることがわかります:

Spark shellの起動

コンソールで、Sparkがポート404でWebコンソールも開いていることがわかります。 のは、それを訪問を与えてみましょう:

Apache Spark Web Console

コンソール自体で動作しますが、web環境は、実行する各Sparkジョブで何が起こっているのかを知るために、重いSparkジョブを実行す

簡単なコマンドでSparkシェルのバージョンを確認します:

私たちは次のようなものを取り戻します:

ScalaでSparkアプリケーションのサンプルを作る

ここでは、Apache Sparkでワードカウンターアプリケーションのサンプルを作ることにします。 これを行うには、最初にSpark shellのspark Contextにテキストファイルをロードします:

Data:org.アパッチスパークrddだRDD=/root/LinuxHint/spark/README.md MapPartitionsRDD at textFile at :24

>

これで、ファイルに存在するテキストは、Sparkが管理できるトークンに分割する必要があります:

トークン:org.アパッチスパークrddだRDD=MapPartitionsRDD at flatMap at:25

scala>

ここで、各単語のカウントを初期化して、次のようにします1:

tokens_1:org.アパッチスパークrddだRDD=MapPartitionsRDD at map at:25

scala>

最後に、ファイルの各単語の頻度を計算します:

プログラムの出力を見る時間。 トークンとそれぞれのカウントを収集します:

res1:Array=Array((package,1),(For,3),(Programs,1),(processing.,1),(ため,1),(ザ,1),(ページ](http://spark.apache.org/documentation.html).,1),(クラスター.,1),(its,1),([run,1),(than,1),(Api,1),(have,1),(Try,1),(computation,1),(through,1),(several,1),(This,2),(graph,1),(Hive,2),(storage,1),([“指定,1),(To,2),(“yarn”,1),(Once,1),([“有用,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),(prefer,1),sparkpi,2),(エンジン,1),(バージョン,1),(ファイル,1),(ドキュメント,,1),(処理,,1),(ザ,24),(あります,1),(システム.,1),(params,1),(not,1),(different,1),(refer,2),(Interactive,2),(R,,1),(given.1)、(If,4)、(build,4)、(when,1)、(be,2)、(Tests,1)、(Apache,1)、(thread,1)、(programs,,1)、(including,4)、(./bin/run-例,2),(Spark.、1)、(パッケージ。,1), (1000).count(),1),(Versions,1),(HDFS,1),(D…

>

優れた! Scalaプログラミング言語を使用して、システムに既にテキストファイルが存在する簡単なWordカウンターの例を実行することができました。

結論

このレッスンでは、Ubuntu17.10マシンにApache Sparkをインストールして使用を開始し、その上でサンプルアプリケーションを実行する方法を見ました。