아파치 스파크는 데이터를 처리하는 데 사용할 수있는 데이터 분석 도구입니다. 이 게시물에서,우리는 우분투에 아파치 스파크를 설치합니다 17.10 기계.

우분투 버전

이 가이드에서는 우분투 버전 17.10 을 사용합니다.

아파치 스파크는 빅 데이터를 위한 하둡 에코시스템의 일부이다. 아파치 하둡 설치를 시도하고 그것으로 샘플 응용 프로그램을 확인합니다.

기존 패키지 업데이트

스파크 설치를 시작하려면 최신 소프트웨어 패키지로 시스템을 업데이트해야 합니다. 우리는 이것을 할 수 있습니다:

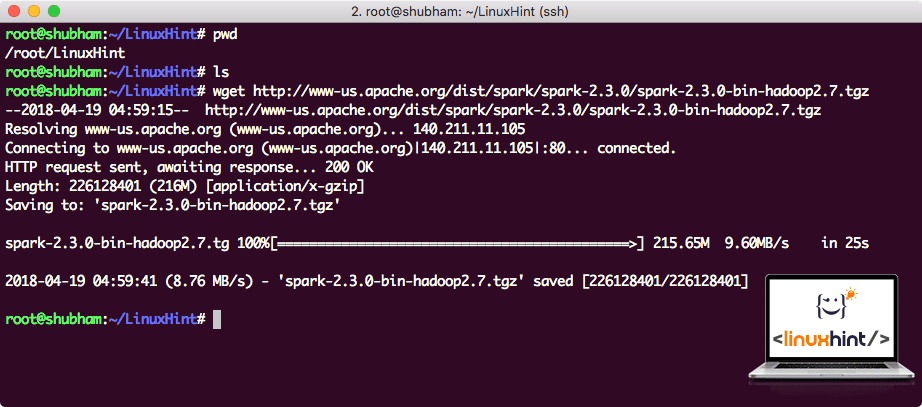

다운로드 불꽃을 파

필요한 모든 패키지에 존재하는 우리의 기계입니다. 우리는 우리가 그들을 설정을 시작뿐만 아니라 스파크와 샘플 프로그램을 실행할 수 있도록 필요한 스파크 타르 파일을 다운로드 할 준비가 된 것입니다.

이 가이드에서,우리는 여기에 사용할 수 스파크 2.3.0 을 설치하는 것입니다:

스파크 다운로드 페이지

이 명령으로 해당 파일 다운로드:

네트워크 속도에 따라 파일 크기가 크므로 최대 몇 분 정도 걸릴 수 있습니다:

아파치 스파크 다운로드

이제 우리는 타르 파일을 다운로드 한 것을,우리는 현재 디렉토리에서 추출 할 수 있습니다:

스파크에 보관되지 않은 파일

향후 아파치 스파크를 업그레이드 할 때 경로 업데이트로 인해 문제가 발생할 수 있습니다. 이러한 문제는 스파크 소프트 링크를 생성하여 피할 수 있습니다. 이 명령을 실행하는 소프트 링크:

추가하기에 불꽃을 경로

실행 Spark 스크립트,우리는 것에 추가하는 경로가 지금입니다. 이렇게 하려면 다음을 수행합니다:

경로에 스파크 추가

이러한 변경 내용을 활성화하려면 다음 명령을 실행하십시오.:

스파크 쉘이 열려 있음을 알 수 있습니다.:

스파크 쉘 시작

콘솔에서 스파크가 포트 404 에서 웹 콘솔을 열었다는 것을 알 수 있습니다. 의 그것을 방문을 제공 할 수 있습니다:

아파치 스파크 웹 콘솔

우리는 콘솔 자체에서 작동 할 것이지만,웹 환경은 당신이 실행하는 각 스파크 작업에서 무슨 일이 일어나고 있는지 알 수 있도록 무거운 스파크 작업을 실행할 때 볼 수있는 중요한 장소입니다.

간단한 명령으로 스파크 쉘 버전 확인:

우리는 다음과 같은 것을 다시 얻을 것입니다:

스칼라

와 샘플 스파크 응용 프로그램 만들기 이제,우리는 아파치 스파크와 샘플 워드 카운터 응용 프로그램을 만들 것입니다. 이렇게 하려면 먼저 텍스트 파일을 스파크 셸의 스파크 컨텍스트에 로드합니다:

스칼라>

이제 파일에 있는 텍스트는 스파크가 관리할 수 있는 토큰으로 구분되어야 합니다:

이제 각 단어의 수를 다음과 같이 초기화하십시오 1:

tokens_1:org.아파치.스파크.루드디25

스칼라>

마지막으로 파일의 각 단어의 빈도를 계산하십시오:2015 년 11 월 1 일-2015 년 11 월 1 일-2015 년 11 월 1 일-2015 년 11 월 1 일-2015 년 11 월 1 일이 방법은 다음과 같습니다.)

프로그램에 대한 출력을 볼 시간입니다. 토큰 및 각각의 수를 수집:

스칼라>

훌륭한! 우리는 시스템에 이미 존재하는 텍스트 파일과 함께 스칼라 프로그래밍 언어를 사용하여 간단한 단어 카운터 예제를 실행할 수있었습니다.

결론

이 단원에서는 우분투 17.10 머신에 아파치 스파크를 설치하고 사용하는 방법을 살펴보았습니다.

여기에 우분투 기반의 게시물을 읽어보십시오.