o Apache Spark é uma ferramenta de análise de dados que pode ser usada para processar dados de HDFS, S3 ou outras fontes de dados na memória. Neste post, vamos instalar o Apache Spark em uma máquina Ubuntu 17.10.

versão do Ubuntu

para este guia, usaremos a versão 17.10 do Ubuntu (GNU/Linux 4.13.0-38-generic x86_64).O Apache Spark faz parte do ecossistema Hadoop para Big Data. Tente instalar o Apache Hadoop e faça um aplicativo de amostra com ele.

Atualizando pacotes existentes

para iniciar a instalação do Spark, é necessário atualizar nossa máquina com os pacotes de software mais recentes disponíveis. Podemos fazer isso com o:

Como Faísca é baseado em Java, precisamos instalá-lo em nossa máquina. Podemos usar qualquer versão Java acima do Java 6. Aqui, vamos usar o Java 8:

baixando arquivos Spark

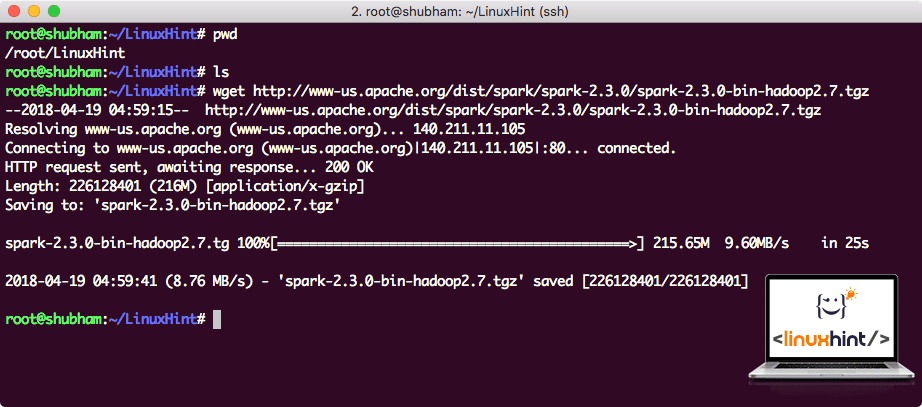

todos os pacotes necessários agora existem em nossa máquina. Estamos prontos para baixar os arquivos Spark TAR necessários para que possamos começar a configurá-los e executar um programa de exemplo com o Spark também.

neste guia, vamos instalar Faísca v2.3.0 disponível aqui:

Faísca página de download

Baixar os arquivos correspondentes com este comando:

Dependendo da velocidade da rede, isso pode demorar alguns minutos, pois o arquivo é grande em tamanho:

Download Apache Faísca

Agora que temos o arquivo TAR baixado, podemos extrair no diretório atual:

isso levará alguns segundos para ser concluído devido ao grande tamanho do arquivo:

arquivos não arquivados no Spark

quando se trata de atualizar o Apache Spark no futuro, ele pode criar problemas devido a atualizações de caminho. Esses problemas podem ser evitados criando um softlink para o Spark. Execute este comando para fazer um softlink:

adicionando Spark ao caminho

para executar scripts Spark, estaremos adicionando-o ao caminho agora. Para fazer isso, abra o arquivo bashrc:

adicione essas linhas ao final do .bashrc arquivo, para que o caminho pode conter a Faísca caminho do ficheiro executável:

export PATH=$SPARK_HOME/bin:$PATH

Agora, o arquivo se parece com:

Adicionar brilho ao CAMINHO

Para ativar essas alterações, execute o seguinte comando para o arquivo bashrc:

iniciando o Spark Shell

agora, quando estivermos fora do diretório spark, execute o seguinte comando para abrir o apark shell:

Vamos ver que estimulam a shell é openend agora:

Lançamento Faísca shell

podemos ver no console que tem uma Centelha também abriu um Console da Web na porta 404. Vamos dar uma visita:

Apache Spark Web Console

embora estejamos operando no próprio console, o ambiente da web é um lugar importante a ser observado quando você executa trabalhos pesados do Spark para saber o que está acontecendo em cada trabalho do Spark executado.

Verifique a versão do Spark shell com um comando simples:

Vamos receber de volta algo como:

Fazendo um exemplo de Ignição Aplicativo com Scala

Agora, vamos fazer um exemplo de Contador de palavras de aplicações com Apache Faísca. Para fazer isso, primeiro carregue um arquivo de texto no contexto do Spark no Spark shell:

scala>

agora, o texto presente no arquivo deve ser dividido em tokens que o Spark pode gerenciar:

scala>

Agora, iniciar a contagem para cada palavra, para 1:

tokens_1: org.Apache.faisca.rdd.RDD = MapPartitionsRDD no mapa em: 25

scala>

por fim, calcule a frequência de cada palavra do arquivo:

hora de olhar para a saída do programa. Colete os tokens e suas respectivas contagens:

res1: Array = Array ((pacote, 1), (Para, 3), (Programas, 1), (processamento.,1), (porque, 1), (o, 1), (página] (http://spark.apache.org/documentation.html)., 1), (cluster.,1), (a sua,1), ([executar,1), (de,1), (APIs,1), (ter,1), (Tentar,1), (computação,1), (através,1), (vários,1), (Este,2), (gráfico 1), (Seção 2), (armazenamento,1), ([“Especificando,1), (A,2), (“fio”,1), (uma Vez que,1), ([“Útil,1), (preferir,1), (SparkPi,2), (motor,1), (versão 1), (arquivo,1), (documentação,1), (processamento,,1), (a,24), (e,1), (sistemas.,1), (params,1), (não,1), (diferente,1), (consulte,2), (interativo, 2), (R,, 1), (dado.,1), (if, 4), (build, 4), (when, 1), (be, 2), (Tests, 1), (Apache, 1), (thread, 1), (programs,, 1), (including, 4), (./ bin / run-exemplo, 2), (faísca., 1), (pacote.,1), (1000).contagem (), 1), (versões,1), (HDFS, 1), (D…

scala>

excelente! Conseguimos executar um exemplo simples de contador de palavras usando a linguagem de programação Scala com um arquivo de texto já presente no sistema.

conclusão

nesta lição, analisamos como podemos instalar e começar a usar o Apache Spark na máquina Ubuntu 17.10 e executar um aplicativo de amostra nele também.

leia mais postagens baseadas no Ubuntu aqui.