Apache Spark este un instrument de analiză a datelor care poate fi utilizat pentru a procesa date din HDFS, S3 sau alte surse de date din memorie. În acest post, vom instala Apache Spark pe o mașină Ubuntu 17.10.

versiunea Ubuntu

pentru acest ghid, vom folosi Ubuntu versiunea 17.10 (GNU/Linux 4.13.0-38-generic x86_64).

Apache Spark face parte din ecosistemul Hadoop pentru Big Data. Încercați să instalați Apache Hadoop și să faceți o aplicație de probă cu ea.

Actualizarea pachetelor existente

pentru a începe instalarea Spark, este necesar să ne actualizăm mașina cu cele mai recente pachete software disponibile. Putem face acest lucru cu:

deoarece Spark se bazează pe Java, trebuie să îl instalăm pe mașina noastră. Putem folosi orice versiune Java deasupra Java 6. Aici, vom folosi Java 8:

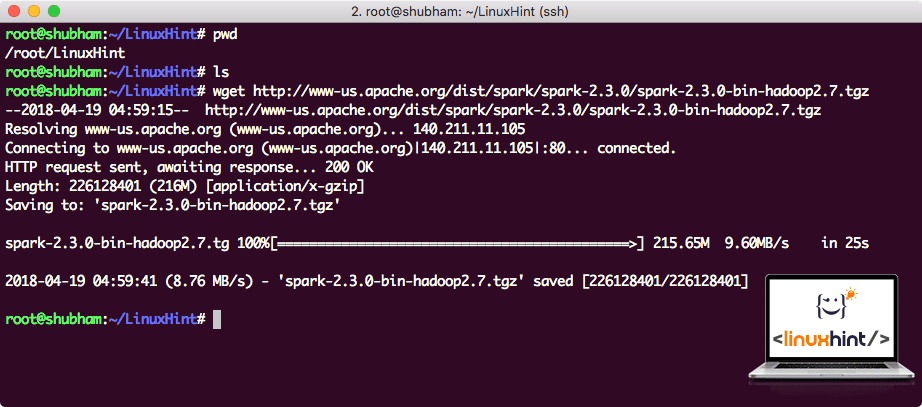

descărcarea fișierelor Spark

toate pachetele necesare există acum pe mașina noastră. Suntem gata să descărcăm fișierele Spark TAR necesare, astfel încât să putem începe să le configurăm și să rulăm și un program de probă cu Spark.

în acest ghid, vom instala Spark v2.3.0 disponibil aici:

pagina de descărcare Spark

descărcați fișierele corespunzătoare cu această comandă:

în funcție de viteza rețelei, aceasta poate dura până la câteva minute, deoarece fișierul are dimensiuni mari:

descărcarea Apache Spark

acum, că avem fișierul TAR descărcat, putem extrage în directorul curent:

acest lucru va dura câteva secunde pentru a finaliza din cauza dimensiunii mari de fișier a arhivei:

fișiere Nearhivate în Spark

când vine vorba de actualizarea Apache Spark în viitor, poate crea probleme din cauza actualizărilor de cale. Aceste probleme pot fi evitate prin crearea unui softlink la Spark. Rulați această comandă pentru a crea un softlink:

adăugarea Spark la Calea

pentru a executa script-uri Spark, vom fi adăugarea la calea acum. Pentru aceasta, deschideți fișierul bashrc:

adăugați aceste linii la sfârșitul .fișier bashrc, astfel încât calea să poată conține calea fișierului executabil Spark:

export PATH= $ SPARK_HOME / bin: $ PATH

acum, fișierul arată ca:

adăugarea Spark La PATH

pentru a activa aceste modificări, executați următoarea comandă pentru fișierul bashrc:

lansarea Spark Shell

acum, când suntem chiar în afara directorul spark, executați următoarea comandă pentru a deschide apark shell:

vom vedea că Spark shell este openend acum:

lansarea Spark shell

putem vedea în consola că Spark a deschis, de asemenea, o consolă Web pe portul 404. Să-i facem o vizită:

Apache Spark Web Console

deși vom fi de operare pe consola în sine, mediul web este un loc important să se uite la atunci când executa locuri de muncă grele Spark, astfel încât să știi ce se întâmplă în fiecare loc de muncă Spark executa.

Verificați versiunea shell Spark cu o comandă simplă:

vom primi înapoi ceva de genul:

efectuarea unui exemplu de aplicație Spark cu Scala

acum, vom face o aplicație contra cuvânt eșantion cu Apache Spark. Pentru a face acest lucru, încărcați mai întâi un fișier text în context Spark pe shell Spark:

date: org.apache.spark.rdd.RDD = /root/LinuxHint/spark / README.md MapPartitionsRDD la fișier text la :24

scala>

acum, textul prezent în fișier trebuie să fie împărțit în jetoane pe care Spark le poate gestiona:

jetoane: org.apache.spark.rdd.RDD = MapPartitionsRDD la flatMap la: 25

scala>

acum, inițializați numărul pentru fiecare cuvânt pentru a 1:

tokens_1: org.apache.spark.rdd.RDD = MapPartitionsRDD la hartă la: 25

scala>

în cele din urmă, calculați frecvența fiecărui cuvânt al fișierului:

timp să se uite la ieșire pentru programul. Colectați jetoanele și numărul lor respectiv:

res1: Array = Array((pachet,1), (Pentru,3), (programe,1), (procesare., 1), (deoarece, 1), (The, 1), (pagina] (http://spark.apache.org/documentation.html).,1), (cluster.,1), (its,1), ([run,1), (than,1), (API-uri,1), (have,1), (Try,1), (calcul,1), (through,1), (mai multe,1), (This,2), (graph,1), (stup,2), (depozitare,1), ([„specificarea,1), (To,2), („fire”,1), (o dată,1), ([„util,1), (prefer,1), (sparkpi,2), (motor,1), (Versiune,1), (fișier,1), (documentație,,1), (prelucrare,,1), (os,24), (sunt,1), (sisteme.,1), (params, 1), (nu, 1), (diferit, 1), (consultați, 2), (interactiv, 2), (R,, 1), (dat.,1), (Dacă, 4), (construi, 4), (Când, 1), (be, 2), (teste, 1), (Apache, 1), (fir, 1), (programe,, 1), (inclusiv, 4), (./ bin / run-exemplu, 2), (scânteie., 1), (pachet.,1), (1000).contele (), 1), (Versiuni, 1), (HDFS, 1), (D…

scala>

excelent! Am reușit să rulăm un exemplu simplu de contor de cuvinte folosind limbajul de programare Scala cu un fișier text deja prezent în sistem.

concluzie

în această lecție, ne-am uitat la modul în care putem instala și începe să utilizați Apache Spark pe Ubuntu 17.10 mașină și rula o aplicație eșantion pe ea, de asemenea.

citiți mai multe postări bazate pe Ubuntu aici.