Apache Spark är ett dataanalysverktyg som kan användas för att bearbeta data från HDFS, S3 eller andra datakällor i minnet. I det här inlägget installerar vi Apache Spark på en Ubuntu 17.10-maskin.

Ubuntu Version

för den här guiden kommer vi att använda Ubuntu version 17.10 (GNU/Linux 4.13.0-38-Generisk x86_64).

Apache Spark är en del av Hadoop-ekosystemet för Big Data. Försök installera Apache Hadoop och gör ett exempelapplikation med det.

uppdatera befintliga paket

för att starta installationen för Spark är det nödvändigt att vi uppdaterar vår maskin med senaste tillgängliga programvarupaket. Vi kan göra detta med:

eftersom Spark är baserat på Java måste vi installera det på vår maskin. Vi kan använda vilken Java-version som helst ovanför Java 6. Här kommer vi att använda Java 8:

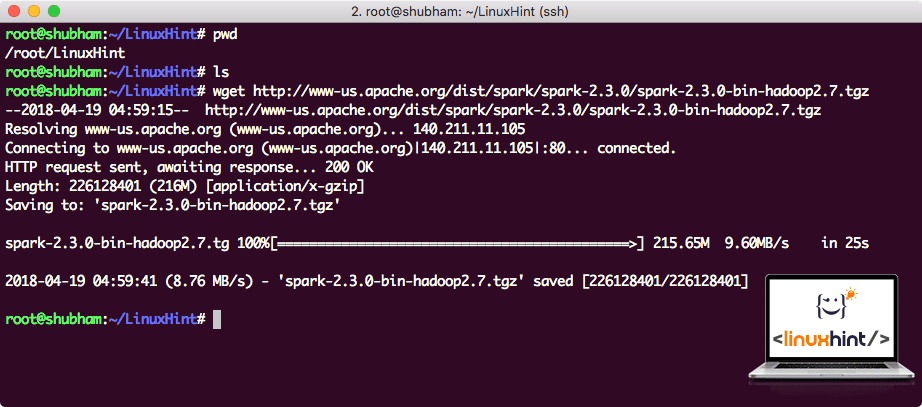

ladda ner Spark-filer

alla nödvändiga paket finns nu på vår maskin. Vi är redo att ladda ner de nödvändiga Spark TAR-filerna så att vi kan börja ställa in dem och köra ett provprogram med Spark också.

i den här guiden kommer vi att installera Spark v2. 3. 0 tillgänglig här:

Spark nedladdningssida

ladda ner motsvarande filer med det här kommandot:

beroende på nätverkshastigheten kan det ta upp till några minuter eftersom filen är stor i storlek:

ladda ner Apache Spark

nu när vi har hämtat TAR-filen kan vi extrahera i den aktuella katalogen:

det tar några sekunder att slutföra på grund av arkivets stora filstorlek:

Oarkiverade filer i Spark

när det gäller att uppgradera Apache Spark i framtiden kan det skapa problem på grund av Sökvägsuppdateringar. Dessa problem kan undvikas genom att skapa en softlink to Spark. Kör det här kommandot för att skapa en softlink:

lägga till Spark till Path

för att utföra Spark-skript kommer vi att lägga till den i path nu. För att göra detta, öppna bashrc-filen:

Lägg till dessa rader i slutet av .bashrc-fil så att Sökvägen kan innehålla den körbara filvägen Spark:

export PATH = $SPARK_HOME / bin: $ PATH

nu ser filen ut:

lägga Spark till PATH

för att aktivera dessa ändringar, kör följande kommando för bashrc-fil:

starta Spark Shell

nu när vi är precis utanför spark-katalogen, kör följande kommando för att öppna apark shell:

vi kommer att se att Spark shell är openend nu:

starta Spark shell

vi kan se i konsolen att Spark också har öppnat en webbkonsol på port 404. Låt oss ge det ett besök:

Apache Spark Web Console

även om vi kommer att fungera på konsolen själv, är webbmiljö en viktig plats att titta på när du utför tunga Spark jobb så att du vet vad som händer i varje Spark jobb du utför.

kontrollera Spark shell-versionen med ett enkelt kommando:

vi kommer att få tillbaka något liknande:

göra ett prov Spark ansökan med Scala

nu kommer vi att göra ett prov Word Counter ansökan med Apache Spark. För att göra detta, ladda först en textfil i Spark-sammanhang på Spark shell:

Data: org.Apache.gnista.FUD.RDD = /root/LinuxHint / spark/README. md MapPartitionsRDD på textfil på :24

scala>

nu måste texten som finns i filen delas in i tokens som Spark kan hantera:

tokens: org.Apache.gnista.FUD.RDD = MapPartitionsRDD vid flatMap vid: 25

scala>

initiera nu räkningen för varje ord till 1:

tokens_1: org.Apache.gnista.FUD.RDD = MapPartitionsRDD vid karta på: 25

scala>

slutligen beräkna frekvensen för varje ord i filen:

dags att titta på utgången för programmet. Samla tokens och deras respektive räkningar:

res1: Array = Array ((paket,1), (för,3), (program,1), (bearbetning.,1), (Eftersom,1), (Den, 1), (sida] (http://spark.apache.org/documentation.html)., 1), (kluster.,1), (Dess,1), ([Kör,1), (än,1), (API: er,1), (har,1), (Försök,1), (beräkning,1), (genom,1), (Flera,1), (Detta,2), (graf,1), (bikupa,2), (Lagring,1), ([”specificera,1), (till,2), (”garn”,1), (en gång,1), ([”användbar,1), (föredrar,1), (sparkpi,2), (motor,1), (version,1), (fil,1), (dokumentation,,1), (bearbetning,,1), (den,24), (är,1), (system.,1), (parametrar,1), (INTE,1), (annorlunda,1), (hänvisa,2), (interaktiv, 2), (R,, 1), (given.,1), (om,4), (bygga,4), (när,1), (vara,2), (tester,1), (Apache,1), (tråd,1), (program,,1), (inklusive,4), (./ bin / kör-exempel,2), (gnista., 1), (paket.,1), (1000).räkna (), 1), (versioner, 1), (HDFS, 1), (D…

scala>

utmärkt! Vi kunde köra ett enkelt Word Counter-exempel med Scala-programmeringsspråk med en textfil som redan finns i systemet.

slutsats

i den här lektionen tittade vi på hur vi kan installera och börja använda Apache Spark på Ubuntu 17.10-maskinen och köra en exempelapplikation på den också.

Läs Mer Ubuntu – baserade inlägg här.